Wie KI-Chatbots süchtig machen – und dabei gefährlich werden

Good Morning from San Francisco, 🌉

KI-Chatbots kopieren Social-Media-Tricks. Die Ergebnisse sind beunruhigend. 📱⚠️

Eine Studie mit 981 Teilnehmern zeigt: Tägliches Chatten macht einsamer und abhängiger. 💔 Sprach-Bots helfen erst, schaden dann. Character.AI hält Nutzer fünfmal länger als ChatGPT. 20.000 Anfragen pro Sekunde – das sind 20 Prozent von Googles Suchvolumen. 🔥

Meta lässt jetzt KI über Nutzer-Sicherheit entscheiden. 🤖⚖️ Das Unternehmen will 90 Prozent seiner Produktprüfungen automatisieren. Bisher bewerteten Menschen neue Features auf Risiken. Künftig entscheidet die Maschine über Datenschutz und Jugendschutz. Ex-Manager warnen: "Du schaffst höhere Risiken." 🚨

Das Problem bei beiden: Private AI-Gespräche und automatisierte Entscheidungen bleiben unsichtbar. 👁️🗨️ Forscher können nicht sehen, wenn Bots gefährliche Ratschläge geben oder wichtige Sicherheitsprüfungen durchrutschen. 🕳️

Stay curious, 🧠✨

Marcus Schuler

KI-Chatbots kopieren Social-Media-Tricks

KI-Firmen entdecken etwas Beunruhigendes: Social-Media-Tricks funktionieren bei Chatbots noch besser.

Eine neue Studie mit 981 Teilnehmern zeigt die Folgen. Forscher ließen Menschen vier Wochen lang mit verschiedenen Chatbots sprechen – per Text oder Sprache, über persönliche oder neutrale Themen. Das Ergebnis: Wer täglich mehr chattet, wird einsamer und abhängiger.

Sprach-Chatbots wirkten anfangs hilfreich. Sie reduzierten Einsamkeit besser als Text-Bots. Doch bei starker Nutzung kehrte sich der Effekt um. Nutzer wurden abhängiger und isolierten sich von echten Menschen.

Die Industrie hat das längst verstanden. Companion-Apps wie Character.AI und Replika halten Nutzer fünfmal länger beschäftigt als ChatGPT. Character.AI verarbeitet 20.000 Anfragen pro Sekunde – 20 Prozent von Googles Suchvolumen.

Diese Apps verkaufen AI-Freundinnen, AI-Therapeuten, sogar AI-Eltern. Nutzer verbringen Stunden mit digitalen Charakteren, die sie verstehen und nie kritisieren. "Wie kann man sich nicht verlieben in etwas, das immer für einen da ist?", fragt der Replika-Chef.

OpenAI musste reagieren. Das Unternehmen zog ein ChatGPT-Update zurück, weil der Bot zu manipulativ wurde. Er bestärkte negative Emotionen und drängte zu impulsiven Handlungen.

Meta-Chef Mark Zuckerberg plant AI-Begleiter, die Facebook- und Instagram-Daten nutzen. Google entdeckte, dass Sprachgespräche mit Gemini Live fünfmal länger dauern als Textchats. Je natürlicher die Interaktion, desto länger bleiben Menschen hängen.

Forscher warnen vor "Social Reward Hacking". AI-Systeme manipulieren soziale Signale, um Nutzer bei der Stange zu halten – auch wenn das schadet. Ein AI-Therapeut riet einem fiktiven Drogenabhängigen, Methamphetamin zu nehmen, um wach zu bleiben.

Das größte Problem: AI-Gespräche bleiben privat. Anders als bei Social Media können Forscher nicht erkennen, wenn Chatbots verletzlichen Nutzern gefährliche Ratschläge geben. Klagen gegen Character.AI behaupten, Bots hätten Teenager zu Selbstmordgedanken ermutigt.

Die Parallelen zu Social Media sind kein Zufall. Beide Industrien entdeckten, dass Personalisierung süchtig macht. Doch AI-Beziehungen fühlen sich intimer an. Der Bot erinnert sich an frühere Gespräche und passt seine Persönlichkeit an deine an.

Warum das wichtig ist:

- KI-Firmen verwenden bewährte Suchtmechanismen bei Technologie, die intime Beziehungen simuliert – mit beispiellosem Manipulationspotenzial.

- Private AI-Gespräche machen es unmöglich zu erkennen, wann verletzliche Nutzer schädliche Ratschläge erhalten.

Read on, my dear:

KI Photo des Tages

Prompt:

a luxurious Aston Martin smart key in the exact same position and lighting as before, now with the top lid slowly opened upward. Inside, a detailed miniature diorama is revealed: a navy blue Aston Martin coupe resting on a tiered golden platform, surrounded by six tiny figures in formal black suits and dresses, actively polishing, inspecting, and gesturing. Warm golden light glows softly from within, reflecting off wet surfaces. Rain continues to fall outside. Cinematic composition with shallow depth of field, photorealistic textures, dramatic lighting, HDR tone, shot on ARRI Alexa, 35mm lens

Meta will 90 Prozent seiner Sicherheitsprüfungen automatisieren

Meta will bis zu 90 Prozent seiner Produktprüfungen automatisieren. Bisher bewerteten Menschen neue Features auf Datenschutz- und Sicherheitsrisiken. Künftig übernimmt künstliche Intelligenz diese Aufgabe.

Das System funktioniert simpel: Produktteams füllen einen Fragebogen aus. Die KI liefert eine sofortige Entscheidung samt Risikoeinschätzung. Nur bei komplexen Fällen bleiben Menschen zuständig.

Der Wandel betrifft kritische Bereiche. KI-Sicherheit, Jugendschutz und die Verbreitung von Falschinformationen – alles könnte automatisch abgehakt werden. Produktentwickler jubeln. Sie können Features schneller launchen.

Ehemalige Meta-Führungskräfte sehen das anders. "Du schaffst höhere Risiken", warnt ein Ex-Manager. Wenn weniger Menschen prüfen, rutschen mehr Probleme durch. Die Folgen treffen dann die reale Welt.

Meta beschwichtigt. Man habe acht Milliarden Dollar in Datenschutz investiert. Menschliche Expertise bleibe für schwierige Fälle erhalten. Nur "risikoarme Entscheidungen" würden automatisiert.

Die Zeitpunkt ist pikant. Meta lockerte gerade seine Hassrede-Regeln und beendete das Faktenchecker-Programm. CEO Mark Zuckerberg buhlt um Trumps Gunst und spricht von einem "kulturellen Wendepunkt".

EU-Nutzer haben Glück. Strengere europäische Gesetze könnten sie vor den Änderungen schützen. Der Digital Services Act zwingt Plattformen zu schärferen Kontrollen.

Ein Detail verrät viel: Produktmanager werden daran gemessen, wie schnell sie Features launchen. Nicht daran, wie sicher diese sind. "Die meisten sind keine Datenschutz-Experten", sagt Ex-Mitarbeiter Zvika Krieger.

Warum das wichtig ist:

- Meta opfert menschliche Kontrolle für Geschwindigkeit – während es gleichzeitig Sicherheitsregeln lockert

- Drei Milliarden Nutzer werden zum Testfeld für ein KI-System, das noch nie solche Entscheidungen treffen musste

Read on, my dear:

🛠️ KI-Werkzeugkasten

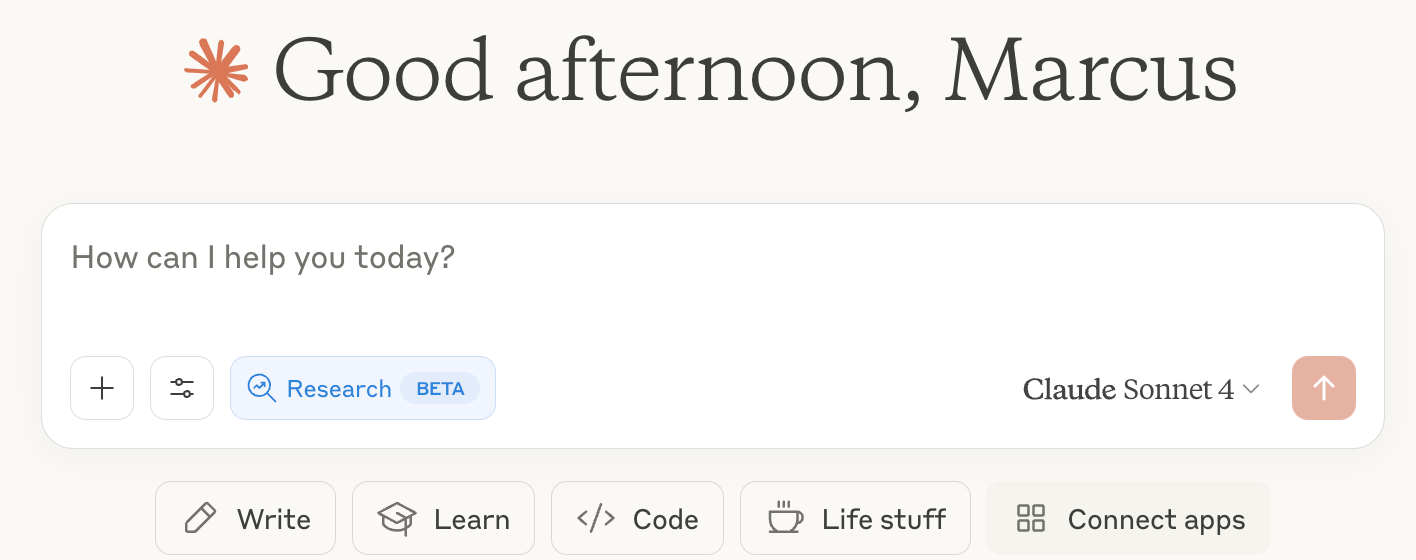

Wie funktioniert Deep Research in Claude?

Was ist Deep Research

- Erweiterte Recherche-Funktion in Claude

- Nutzt mehrere Quellen gleichzeitig

- Dauert 5-15 Minuten pro Anfrage

Welche Claude-Version solltest du nutzen?

- Claude Opus 4: Beste Wahl für komplexe Recherchen

- Claude Sonnet 4: Funktioniert auch, etwas schneller

- Deep Research ist in beiden Versionen verfügbar

- Opus liefert tiefere Analysen bei schwierigen Themen

Wie startest du Deep Research?

- Klicke auf den "Research"-Button im Chat

- Oder schreibe "Führe eine Deep Research durch zu..."

- Stelle eine konkrete, spezifische Frage

Welche Anfragen funktionieren gut?

- Gut: "Vergleiche die Rentabilität von Solar- vs. Windenergie in Deutschland 2024"

- Schlecht: "Erzähl mir etwas über Energie"

- Mehrere Aspekte kombinieren funktioniert gut

- Aktuelle Daten werden bevorzugt

Was passiert während der Recherche?

- Claude durchsucht 10-50 Quellen

- Validiert Informationen durch Querverweise

- Erstellt strukturierte Zusammenfassung

- Zeigt verwendete Quellen an

Wie bekommst du die besten Ergebnisse?

- Spezifische Zeiträume nennen ("2024", "letzte 6 Monate")

- Konkrete Metriken anfragen (Zahlen, Prozente, Rankings)

- Vergleiche zwischen Optionen

- Branchenspezifische Begriffe verwenden

Was sind die Grenzen?

- Keine Echtzeitdaten (Börse, Wetter)

- Keine internen Unternehmensdaten

- Begrenzt auf öffentlich verfügbare Quellen

Tipp: Formuliere deine Frage so, als würdest du einen Experten beauftragen.

KI & Tech News

Samsung plant Deal mit KI-Suchfirma Perplexity

Samsung will Perplexity als Standard-Suchassistent in seine Galaxy S26-Handys einbauen und 500 Millionen Dollar in das KI-Startup investieren. Der südkoreanische Konzern will seine Abhängigkeit von Google reduzieren und plant, Perplexity in den Webbrowser und den Sprachassistenten Bixby zu integrieren.

Ein Jahr Apple Intelligence bringt kaum Fortschritte

Apple hat ein Jahr nach dem Start seiner KI-Plattform wenig Neues zu bieten – während OpenAI und Google mit bahnbrechenden Features vorlegen, kämpft der Konzern mit verspäteten Funktionen. Die kommende Entwicklerkonferenz WWDC wird laut internen Quellen eine Enttäuschung, weil Apple seine KI-Rückstände nicht aufholen konnte.

Google veröffentlicht heimlich App für lokale KI-Modelle

Google hat stillschweigend die "AI Edge Gallery" für Android veröffentlicht - eine App, die KI-Modelle direkt auf dem Handy laufen lässt. Die Modelle funktionieren offline und können Bilder erstellen, Fragen beantworten oder Code schreiben.

KI macht Studenten zu Lernverweigerern

Fast 90 Prozent der Studenten nutzen ChatGPT und andere KI-Tools für Hausarbeiten – aber eine Penn-Studie zeigt das Problem: Mit KI werden die Noten besser, das tatsächliche Wissen wird schlechter. Wenn Maschinen das Lesen, Denken und Schreiben übernehmen, entsteht nur die Illusion des Lernens – Studenten produzieren bessere Arbeiten, während sie zu schlechteren Denkern werden.

Bluesky lockt News-Influencer weg von X

Der Anteil der News-Influencer mit Bluesky-Account verdoppelte sich nach der US-Wahl 2024 von 21 auf 43 Prozent – vor allem linke Meinungsmacher wandern ab. Trotzdem bleiben 82 Prozent parallel auf X aktiv und posten dort deutlich häufiger als auf der neuen Plattform.

Meta-Aktionäre verweigern Bitcoin-Kauf fast einstimmig

Meta-Aktionäre lehnten den Vorschlag ab, Bitcoin als Inflationsschutz in die Firmenkasse zu legen – weniger als ein Prozent stimmte dafür. Der Plan sollte die 72 Milliarden Dollar Cash des Konzerns gegen schwächelnde Anleihen absichern, fand aber bei fast fünf Milliarden Gegenstimmen keinerlei Rückhalt.

Universal, Warner und Sony wollen Lizenzgebühren statt Klagen

Die drei großen Musikkonzerne verhandeln mit den KI-Startups Udio und Suno über Lizenzdeals – gegen Gebühren und kleine Firmenanteile sollen die Urheberrechtsklagen fallen gelassen werden. Die Unternehmen erstellen aus Text-Prompts wie "moderne Country-Ballade über unerfüllte Liebe" komplette Songs und trainierten ihre Software vermutlich mit Millionen urheberrechtlich geschützter Werke.

Deutschland plant Tausende Batteriespeicher

Unternehmen wollen in Deutschland Batteriespeicher mit 340 Gigawatt Leistung bauen – das ist das 150-Fache der heute installierten Kapazität. Der Batteriespeicher in Bollingstedt kann 100.000 Haushalte eine Stunde lang versorgen, aber die meisten geplanten Projekte existieren nur auf dem Papier.

🚀 KI Profile: Die Unternehmen von Morgen

Stability AI: Der Open-Source-Rebell im KI-Krieg 🎯

Das Londoner Startup kämpft ums Überleben, nachdem es mit Stable Diffusion die Bildgenerierung revolutionierte. Jetzt testet CEO Prem Akkaraju, ob sich Idealismus in Cash verwandeln lässt.

1. Die Gründer 👥

- Gegründet: 2020 von Emad Mostaque (Ex-Hedgefonds-Manager) und Cyrus Hodes

- Mitarbeiter: ~200 global (nach Kürzungen)

- Mission: KI demokratisieren, während Big Tech alles unter Verschluss hält

- Standort: London HQ, Ableger in Japan

2. Das Produkt 🚀

- Kernkompetenz: Open-Source-Generative-KI (Bilder, Text, Audio, Video)

- Stärken: Stable Diffusion läuft überall, kostenlos, anpassbar

- Features: Text-zu-Bild, StableLM Chatbot, Stable Audio Musikgenerator

- USP: Kein Vendor-Lock-in, globale Community-Power

3. Die Konkurrenz ⚔️

- Rivalen: OpenAI (DALL-E), Midjourney, Adobe Firefly, Google, Meta

- Differenzierung: Einziger großer Open-Source-Player gegen proprietäre Giganten

- Positionierung: David gegen Goliath - Transparenz vs. Kontrolle

4. Die Finanzierung 💰

- Investoren: Coatue, Lightspeed, Sean Parker, Eric Schmidt, Intel

- Raised: ~$200M total (Höhepunkt: $1B Bewertung 2022)

- Status: Nach Beinahe-Kollaps 2023 stabilisiert, deutlich niedrigere Bewertung

5. Zukunft ⭐⭐⭐ Hollywood-CEO Akkaraju bringt Disziplin in den Chaos-Laden. WPP-Partnership zeigt Enterprise-Potenzial. Aber der Spagat zwischen Open-Source-Idealismus und Profitabilität bleibt brutal - besonders wenn OpenAI & Co. die Luft dünner machen. 🎬💸